安装大模型本地运行利器 ollama

功能介绍

一个便捷的在本地下载和运行大模型的工具

安装与设置

安装

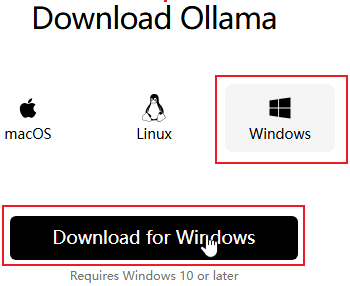

ollama 支持 windows,linux,macOS。下面以 windows11 为例,进行安装。

去 官网下载页 选择 Windows 系统,下载安装文件 OllamaSetup.exe。

双击 OllamaSetup.exe,按照提示一路安装即可(默认安装在:C:\Users\Administrator\AppData\Local\Programs\Ollama)。安装完成之后,在 cmd 中输入

shell

PS C:\Users\Administrator> ollama -v

ollama version is 0.5.7 // 表示安装成功如果不成功,将 C:\Users\Administrator\AppData\Local\Programs\Ollama 配置到环境变量的 Path 变量中

常用设置

ollama 所有可设置参数在执行 ollama serve 启动时,在启动日志中可以看到。常用的设置参数如下,如有需要,设置到环境变量中:

- OLLAMA_MODELS:模型文件的存放目录,默认在 C 盘,建议设置到非系统盘,例如

D:\software\ollama\models - OLLAMA_HOST:ollama 服务监听的网络地址,默认为127.0.0.1,如果想要允许其他电脑访问,设置成 0.0.0.0

- OLLAMA_PORT:ollama 服务监听的默认端口,默认为11434

- OLLAMA_ORIGINS:http 请求来源

- OLLAMA_KEEP_ALIVE:大模型加载到内存中后的存活时间,默认为5m,即5分钟 (如纯数字300代表300秒,0代表处理请求响应后立即卸载模型,任何负数则表示一直存活)

- OLLAMA_NUM_PARALLEL:请求处理的并发数量

- OLLAMA_MAX_QUEUE:请求队列长度,默认值为512,超过队列长度的请求会被抛弃

- OLLAMA_MAX_LOADED_MODELS:最多同时加载到内存中模型的数量,默认为1 (即只能有1个模型在内存中)

更新

默认会自动更新,如果需要手动更新,需要重新下载安装包,重新安装。

核心命令

shell

C:\Users\Administrator>ollama

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

stop Stop a running model

pull Pull a model from a registry

push Push a model to a registry

list List models

ps List running models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information

Use "ollama [command] --help" for more information about a command.以上就是 ollama 可以执行的命令。

列出当前已下载的模型

shell

C:\Users\Administrator>ollama list

NAME ID SIZE MODIFIED

deepseek-r1:32b 38056bbcbb2d 19 GB 11 minutes ago

llama3.1:8b 42182419e950 4.7 GB 3 months ago查看指定模型的信息

shell

C:\Users\Administrator>ollama show deepseek-r1:32b

Model

architecture qwen2

parameters 32.8B

context length 131072

embedding length 5120

quantization Q4_K_M

Parameters

stop "<|begin▁of▁sentence|>"

stop "<|end▁of▁sentence|>"

stop "<|User|>"

stop "<|Assistant|>"

License

MIT License

Copyright (c) 2023 DeepSeek启动 ollama

shell

ollama serve

2025/01/29 12:07:08 routes.go:1187: INFO server config env="map[CUDA_VISIBLE_DEVICES: GPU_DEVICE_ORDINAL: HIP_VISIBLE_DEVICES: HSA_OVERRIDE_GFX_VERSION: HTTPS_PROXY: HTTP_PROXY: NO_PROXY: OLLAMA_DEBUG:false OLLAMA_FLASH_ATTENTION:false OLLAMA_GPU_OVERHEAD:0 OLLAMA_HOST:http://127.0.0.1:11434 OLLAMA_INTEL_GPU:false OLLAMA_KEEP_ALIVE:5m0s OLLAMA_KV_CACHE_TYPE: OLLAMA_LLM_LIBRARY: OLLAMA_LOAD_TIMEOUT:5m0s OLLAMA_MAX_LOADED_MODELS:0 OLLAMA_MAX_QUEUE:512 OLLAMA_MODELS:D:\\software\\ollama\\models OLLAMA_MULTIUSER_CACHE:false OLLAMA_NOHISTORY:false OLLAMA_NOPRUNE:false OLLAMA_NUM_PARALLEL:0 OLLAMA_ORIGINS:[http://localhost https://localhost http://localhost:* https://localhost:* http://127.0.0.1 https://127.0.0.1 http://127.0.0.1:* https://127.0.0.1:* http://0.0.0.0 https://0.0.0.0 http://0.0.0.0:* https://0.0.0.0:* app://* file://* tauri://* vscode-webview://*] OLLAMA_SCHED_SPREAD:false ROCR_VISIBLE_DEVICES:]"

time=2025-01-29T12:07:08.703+08:00 level=INFO source=images.go:432 msg="total blobs: 10"

time=2025-01-29T12:07:08.704+08:00 level=INFO source=images.go:439 msg="total unused blobs removed: 0"

time=2025-01-29T12:07:08.704+08:00 level=INFO source=routes.go:1238 msg="Listening on 127.0.0.1:11434 (version 0.5.7)"

time=2025-01-29T12:07:08.704+08:00 level=INFO source=routes.go:1267 msg="Dynamic LLM libraries" runners="[cuda_v11_avx cuda_v12_avx rocm_avx cpu cpu_avx cpu_avx2]"

time=2025-01-29T12:07:08.704+08:00 level=INFO source=gpu.go:226 msg="looking for compatible GPUs"

time=2025-01-29T12:07:08.704+08:00 level=INFO source=gpu_windows.go:167 msg=packages count=1

time=2025-01-29T12:07:08.704+08:00 level=INFO source=gpu_windows.go:183 msg="efficiency cores detected" maxEfficiencyClass=1

time=2025-01-29T12:07:08.704+08:00 level=INFO source=gpu_windows.go:214 msg="" package=0 cores=16 efficiency=8 threads=24

time=2025-01-29T12:07:08.821+08:00 level=INFO source=gpu.go:334 msg="detected OS VRAM overhead" id=GPU-d110dd87-4fcf-d306-5c3b-9d0aebf99fe5 library=cuda compute=8.9 driver=12.6 name="NVIDIA GeForce RTX 4090" overhead="757.8 MiB"

time=2025-01-29T12:07:08.822+08:00 level=INFO source=types.go:131 msg="inference compute" id=GPU-d110dd87-4fcf-d306-5c3b-9d0aebf99fe5 library=cuda variant=v12 compute=8.9 driver=12.6 name="NVIDIA GeForce RTX 4090" total="24.0 GiB" available="22.5 GiB"启动日志的第一行,env 中列出了所有可设置的环境变量。

下载指定模型

shell

PS C:\Users\Administrator> ollama pull deepseek-r1:32b在 此处 可以查看 ollama 支持的所有模型,选择一个模型进行模型下载主页,如下所示:

复制命令,进行 cmd 进行执行,即可下载并运行模型

运行指定模型

shell

PS C:\Users\Administrator> ollama run deepseek-r1:32b

>>>如果模型没有下载过,则会先下载模型,再运行。

查看正在运行的模型

shell

PS C:\Users\Administrator> ollama ps

NAME ID SIZE PROCESSOR UNTIL

deepseek-r1:32b 38056bbcbb2d 23 GB 100% GPU 4 minutes from now文章的最后,如果您觉得本文对您有用,请打赏一杯咖啡!感谢!